部署 OpenWebUI 并接入 Chutes.ai 的完整教程

部署 OpenWebUI 并接入 Chutes.ai 的完整教程

Weekend🚀 部署 OpenWebUI 并接入 Chutes.ai 的完整教程

本文将带你从零开始部署 OpenWebUI(原 Ollama WebUI),并将其无缝接入 Chutes.ai 分布式推理网络,让你的浏览器瞬间变身为一站式 AI 工作台,可直接调用 Chutes 的推理算力节点,实现低延迟、高性能的本地或远程模型交互体验。

一、背景介绍

随着 Chutes.ai 生态的快速发展,越来越多开发者希望将其高性能 GPU 推理能力接入自定义的 Web 界面进行模型交互和可视化。

而 OpenWebUI 是一个轻量、现代化的开源前端界面,可与多种后端推理引擎(如 Ollama、OpenAI API、vLLM、Chutes API 等)对接。

通过本文,你将实现:

- ✅ 本地部署 OpenWebUI

- ✅ 配置连接 Chutes.ai 提供的推理接口

- ✅ 自定义模型、参数与多用户管理

- ✅ 打造属于你自己的 AI 控制台

二、环境准备

1. 系统要求

| 项目 | 要求 |

|---|---|

| 操作系统 | Ubuntu 22.04 / Debian 12 / CentOS 9 / macOS / Windows (WSL2) |

| CPU | x86_64 / ARM64 均可 |

| 内存 | ≥ 4 GB |

| 网络 | 能访问 Chutes.ai API 端点 |

| 软件依赖 | Docker + Docker Compose |

2. 安装 Docker 与 Compose

1 | sudo apt update |

检查安装结果:

1 | docker --version |

三、部署 OpenWebUI

1. 拉取官方镜像

1 | docker pull ghcr.io/open-webui/open-webui:main |

2. 创建数据卷与配置目录

1 | mkdir -p ~/openwebui/{data,config} |

3. 创建 docker-compose.yml

在 ~/openwebui/ 目录下新建文件:

1 | version: "3" |

💡

CHUTES_API_KEY为你在 Chutes 平台获取的访问密钥。

4. 启动容器

1 | cd ~/openwebui |

启动后访问:

1 | http://localhost:3000 |

首次访问会提示创建管理员账号。

四、接入 Chutes.ai

1. 获取 API 凭证

登录 https://chutes.ai

→ 控制台 → API Keys → 新建密钥。

复制生成的 API Key。

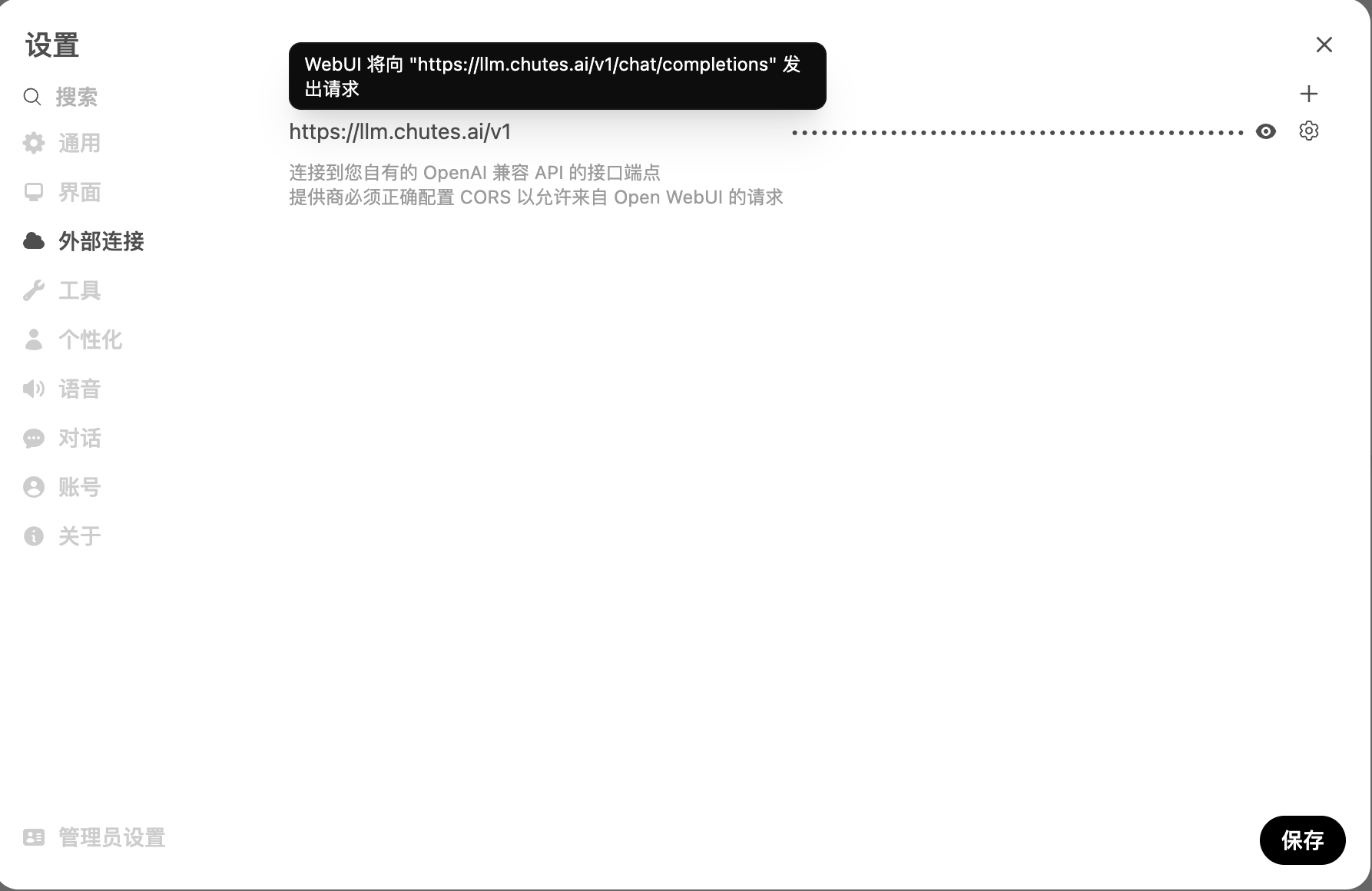

2. 在 OpenWebUI 中配置 Chutes Endpoint

打开 WebUI 管理后台 → Settings → API Configuration

填写以下内容:

- Base URL:

https://api.chutes.ai/v1 - API Key: 粘贴你刚生成的密钥

- Model: 输入可用模型 ID,例如:

1 | chutes/sglang-70b |

- Proxy Mode: ✅ 开启(若你本地网络需代理)

保存后即可开始调用 Chutes 模型进行推理。

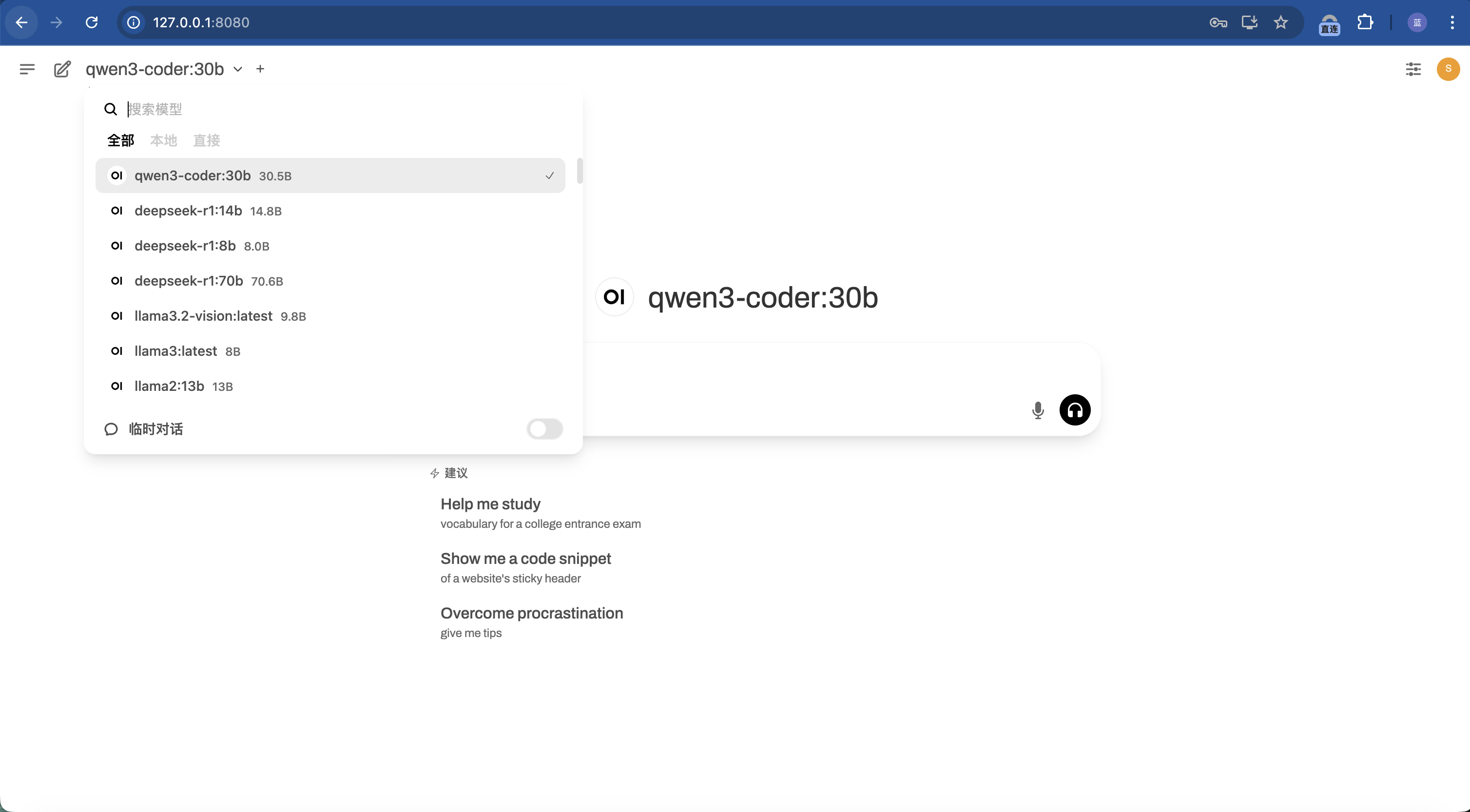

五、自定义参数与多模型切换

OpenWebUI 支持动态切换模型与参数:

- 温度 (temperature):控制随机性(默认 0.7)

- 最大输出长度 (max_tokens):限制生成长度

- Top-p / Top-k:控制采样多样性

- System Prompt:自定义模型人格设定

在主界面左下角的 “⚙️ 设置 → 模型配置” 中可修改默认参数。

六、常见问题与解决方案

| 问题 | 可能原因 | 解决方法 |

|---|---|---|

| 无法连接 Chutes API | 网络或防火墙问题 | 检查网络出口能否访问 api.chutes.ai |

| 提示 401 Unauthorized | API Key 无效 | 重新生成密钥并更新 .env |

| 模型列表为空 | Base URL 配置错误 | 确保为 https://api.chutes.ai/v1 |

| Docker 启动失败 | 端口被占用 | 修改 docker-compose.yml 中的端口号 |

七、进阶玩法

启用多用户模式

1

WEBUI_AUTH=True

多人共享访问、各自保存会话历史。

外网访问配置

可通过反向代理(如 Nginx / Caddy)绑定域名并启用 HTTPS。与 Chutes Subnet 自建节点集成

如果你已运行 Chutes Miner 或 Validator 节点,可在本地部署私有推理接口,再在 OpenWebUI 中指向该本地 Endpoint,实现完全去中心化的交互体验。

八、总结

通过以上步骤,你已成功在本地部署了 OpenWebUI 并接入了 Chutes.ai 分布式 AI 网络。

现在你可以在浏览器中自由切换模型、管理会话、甚至连接自己的子网节点,实现一个强大的 AI 控制中心。

推荐阅读: